大模型解剖术:方方-王茜团队提出可通用于人脑与大模型的句法层级探针技术

句法是语言结构与智能生成的核心支架。乔姆斯基提出的递归层级理论认为,句法加工使人类能够以有限规则生成无限意义。随着大语言模型在文本生成、翻译与推理中展现出接近人类的表现,一个根本性问题逐渐凸显:人工智能是否也具备类人的句法理解机制?

2025年10月,北京大学心理与认知科学学院、IDG麦戈文脑科学研究所方方教授与王茜副研究员团队联合浙江大学、北京语言大学、北京通用人工智能研究院等单位,在人工智能与脑科学交叉研究中取得重要进展。团队提出“层级化频率标记探针(Hierarchical Frequency Tagging Probe, HFTP)”通用技术,在同一计算框架下比较人脑与多种大语言模型的句法层级结构加工机制。相关成果发表于人工智能顶级会议 NeurIPS 2025[1]。

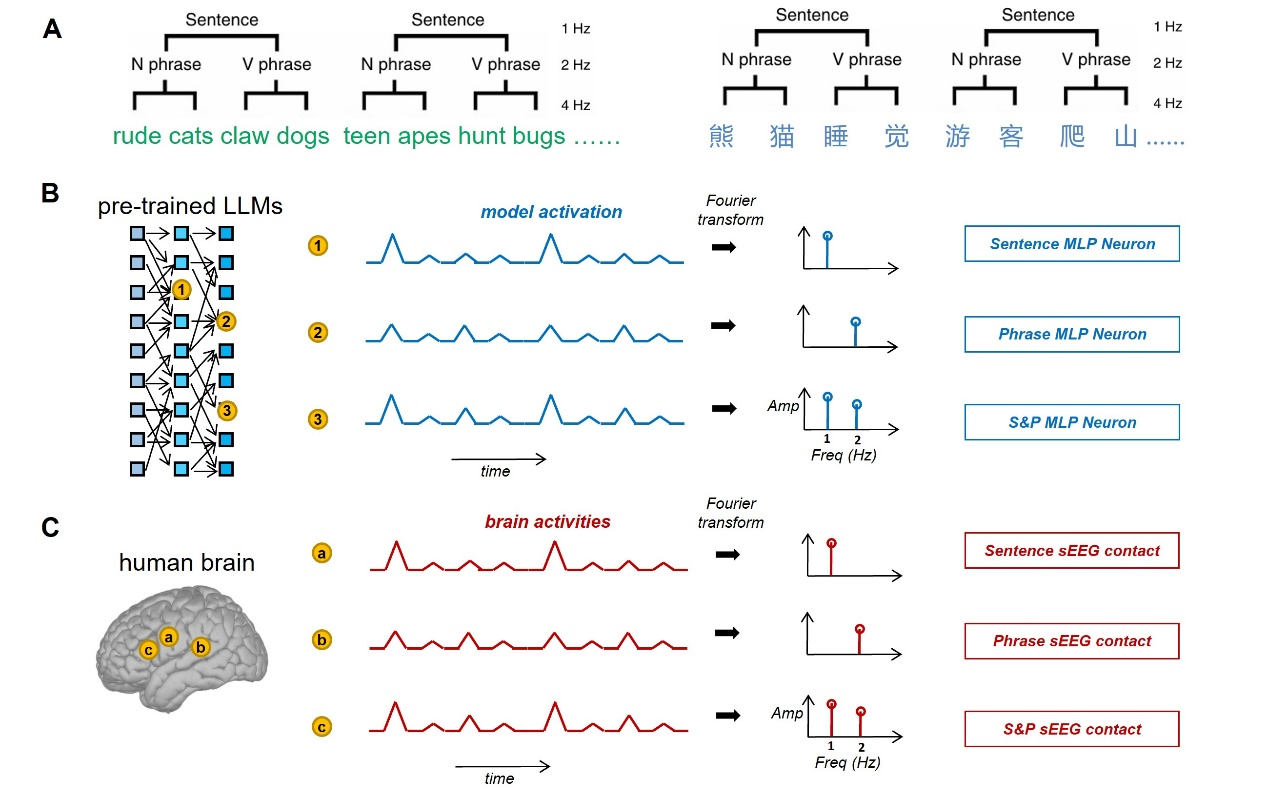

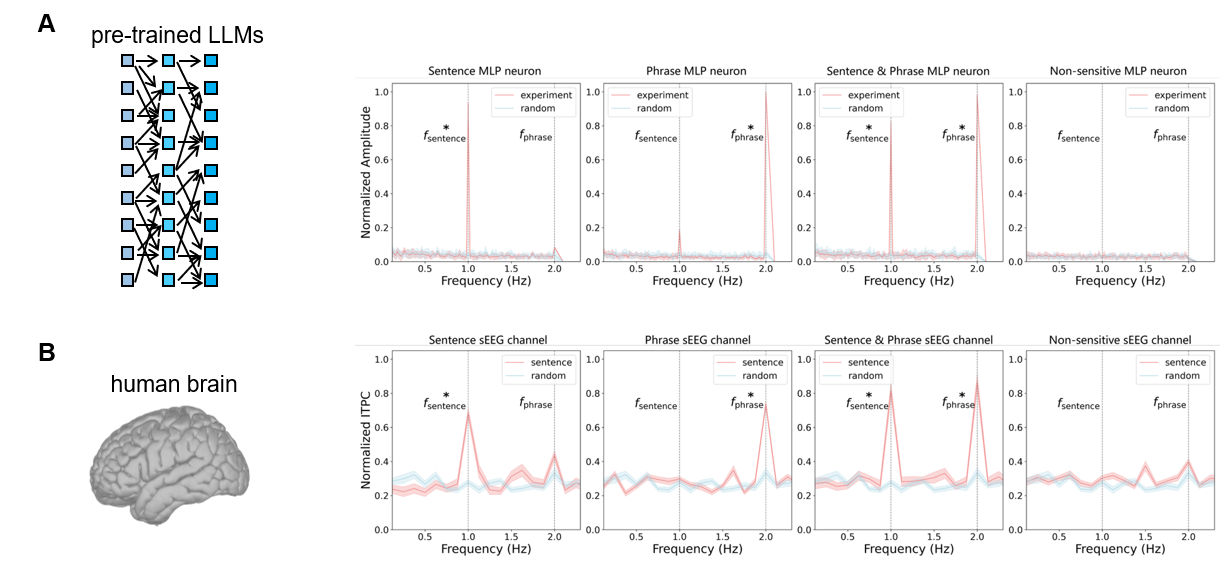

研究团队基于丁鼐等人于2016年提出的层级化频率标记(Hierarchical Frequency Tagging, HFT)方法[2],构建了中英文平行句法语料,并在人脑与大模型中同步应用。人脑实验中,研究者利用颅内立体脑电(stereo-electroencephalography, sEEG)记录人类受试者在4 Hz节奏下聆听句子的神经活动;模型实验中,研究团队为GPT、Llama、Gemma与GLM等模型构建了虚拟时间轴,并将模型内部激活信号映射到频域。结果显示,人脑和模型均在1 Hz(句子)与2 Hz(短语)频段产生稳定的特征响应,表明二者在层级化句法加工上存在共通的结构节律。

图1. HFTP实验范式与三种不同句法层级编码计算单元定义

图2. A. GPT-2在第六层的神经元所产生的层次化句法加工模式; B. 人脑颞中回的层次化句法加工模式

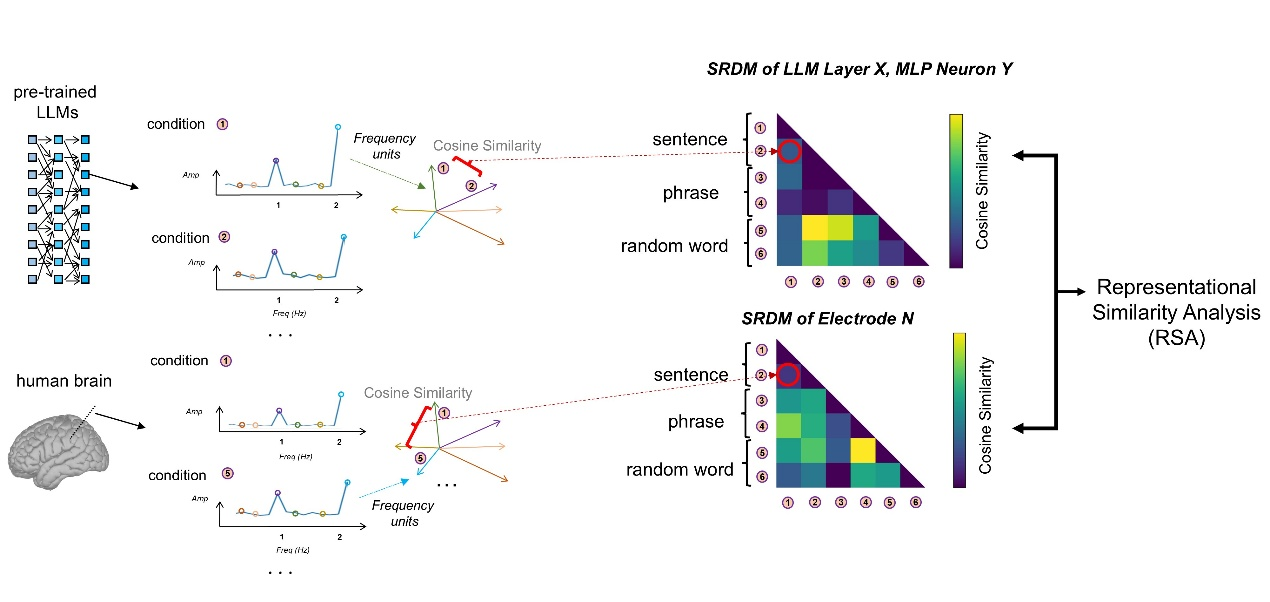

进一步分析发现,无论在生物神经系统还是人工神经网络中,都可识别出三类功能单元:分别特异性处理句子、处理短语,以及同时参与两级加工的“共享单元”。这一跨系统对应关系实现了人脑神经表征与模型内部表征在频谱空间的句法表征对齐(representational alignment),从而揭示了语言层级结构的普适规律。

图3. 运用HFTP技术的表征对齐工作流程

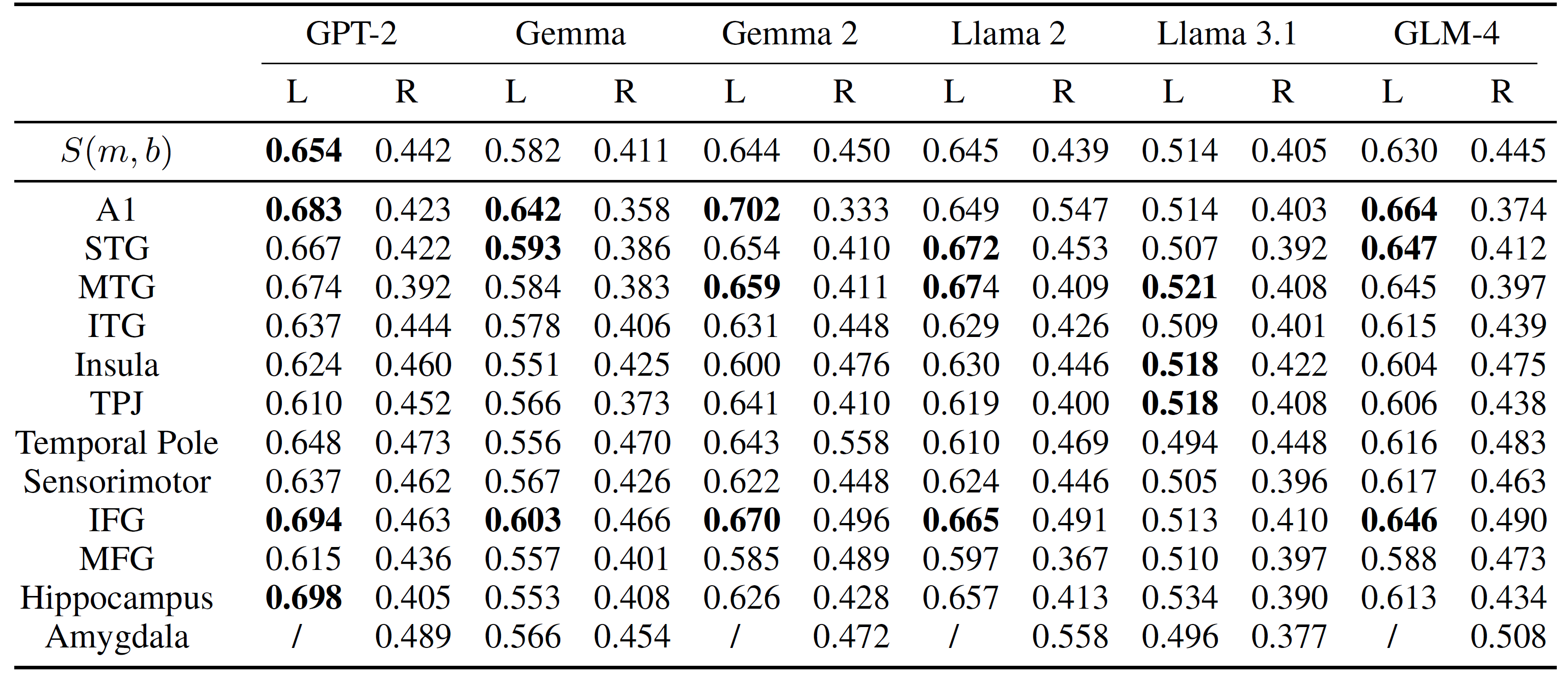

研究还发现,不同模型与人脑的对齐程度并不随模型规模单调提升。例如,Gemma 2与人脑的相似性高于前代Gemma,而Llama 3.1则低于Llama 2。这一结果表明,模型性能的提升未必通过更“类人”的方式实现。不同的智能体可能采用各自独立的结构策略抵达语言理解的功能层面。

表1. 不同大模型与人脑的句法对齐表现

Sm, b:模型-人脑相似性

HFTP框架不仅为人工智能可解释性研究提供了新的定量范式,也为理解智能本质提供了新的思考视角。研究结果暗示:人类智能可能并非智能形成的唯一范式。在类脑与非类脑之间,或许存在多条通向复杂认知的演化路径,而语言理解只是这些智能体系相互映照的共同界面。

本文第一作者为北京大学前沿交叉学科研究院博士生安靖民。通讯作者为方方教授与王茜副研究员。北京大学前沿交叉学科研究院硕士生宋奕龙,博士生杨若霖、庄楚,计算机学院博士生王宇萱,浙江大学生物医学工程与仪器科学学院丁鼐研究员,北京语言大学陆灵犀研究员,北京通用人工智能研究院王威研究员对本工作做出了重要贡献。本工作得到了国家自然科学基金(32441106、32171039、T2421004)和科技创新2030重大专项(2022ZD0204804、2022ZD0204802)等项目资助。

参考文献

[1] Jingmin An, et al. Hierarchical Frequency Tagging Probe (HFTP): A Unified Approach to Investigate Syntactic Structure Representations in Large Language Models and the Human Brain. Advances in Neural Information Processing Systems (NeurIPS) (2025).

[2] Ding, N., Melloni, L., Zhang, H., Tian, X. & Poeppel, D. Cortical tracking of hierarchical linguistic structures in connected speech. Nat Neurosci 19, 158–164 (2016).

论文链接:

https://neurips.cc/virtual/2025/poster/117236

代码链接:

https://github.com/LilTiger/HFTP